Hinweis: Diese Dokumentation ist eine Vorab-Version und nicht final.

A/B-Testen

A/B-Testen

A/B-Testen ist ein Add-on und erfordert eine separate Installation, da es nicht standardmäßig in einer Episerver-Installation enthalten ist. Das Add-on A/B-Testen erfordert keine zusätzliche Lizenz.

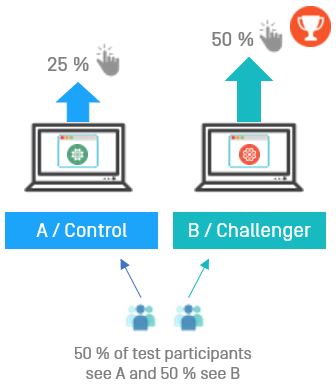

Mit A/B-Testen können Sie verschiedene Versionen für eine Anzahl von Seitenelementen (Blöcke, Bilder, Inhalt, Schaltflächen, Formularfelder usw.) erstellen und dann vergleichen, welche Version am besten funktioniert. Es misst die Anzahl von KonversionenEin Konversion findet statt, wenn ein Website-Besucher eine gewünschte Handlung ausführt. Eine solche Handlung kann zum Beispiel der Kauf eines Artikels, das Ausfüllen eines Formulars oder das Klicken auf einen Link sein., die mit dem Original (Kontrolle) im Vergleich zur Variation (Alternative) erzielt wurden. Die Version, die während des Testzeitraums die meisten Konversionen erzielt hat, wird meist als Design für diese Seite übernommen. A/B-Testen hat mehrere vordefinierte Konversionsziele, die Sie für den Test festlegen können. Episerver-Entwickler können außerdem eigene Konversionsziele erstellen.

Wie das funktioniert

Nehmen wir an, Sie möchten wissen, ob eine andere Werbeanzeige mehr Interesse bei Ihren Website-Besuchern hervorruft. Mit A/B-Testen können Sie zwei Seitenversionen mit verschiedenen Werbeinhalten erstellen, die mit einer ZielseitePunycode ist ein Weg zur Umwandlung von Internet-Hostnamen von Unicode zu ASCII. verknüpft sind. Stellen Sie den A/B-Test auf das Konversionsziel Landeseite ein, das misst, wie viele Besucher auf die Anzeige geklickt haben und auf der Zielseite gelandet sind.

- Wenn ein Besucher Ihre A/B-Testseite aufruft, wird ihm entweder die Originalseite (A / Kontrolle) oder die Variation (B / Herausforderung) gezeigt. Der A/B-Test protokolliert, welche Version der Besucher sieht. Wenn ein Besucher zur Testseite zurückkehrt, sieht er dieselbe Version (A oder B) während der gesamten Testdauer. Löscht der Besucher jedoch seine Cookies, bevor er zur Testseite zurückkehrt, wird er als neuer Besucher registriert.

- Klickt ein Besucher auf die Anzeige, erscheint die Zielseite und A/B-Testen protokolliert den Vorgang als eine Konversion.

- Die Version, die nach Ablauf der Testdauer das beste Ergebnis (d. h. die meisten Klicks) erhalten hat, gilt als Gewinner des Tests.

- Je nach Ihren Einstellungen können Sie den Gewinner (gewöhnlich die Seite mit den meisten Konversionen) manuell auswählen oder er wird nach Ablauf des Tests automatisch veröffentlicht. Testgewinner werden nur dann automatisch veröffentlicht, wenn die Ergebnisse statistisch signifikant sind. Weitere Informationen über die statistische Bedeutung von A/B-Tests erfahren Sie untenstehend im Abschnitt Statistische Signifikanz.

Statistische Signifikanz

Statistische Signifikanz ist eine Berechnung, die bestimmt, ob ein Testergebnis „signifikant“ ist oder nicht. Es handelt sich um eine Funktion der Anzahl von Aufrufen und der Konversionen der Versionen. So kann eine Version, die mit großem Unterschied gewinnt, obwohl sie eine relativ geringe Anzahl von Aufrufe erzielt, auch so als statistisch signifikanter Gewinner des Tests berechnet werden. Andererseits kann ein Test, in dem zwar eine viel größere Zahl von Aufrufen erreicht wurde, die Konversionsraten aber viel knapper ausfällt, Ergebnisse aufweisen, die nicht als signifikant angesehen werden. Theoretisch kann eine statistische Signifikanz an jedem Punkt im Test erreicht werden. Das geschieht hier jedoch nicht. A/B-Testen führt den Test bis zum Ende durch, bevor die Berechnung zur Erklärung eines „signifikanten“ Unterschieds durchgeführt wird.

Wie viele Aufrufe sind also nötig, um eine statistische Signifikanz zu gewährleisten? Die Antwort hängt von der Konversionsspanne ab, mit der die gewinnende Version gewinnt.

Konfidenzniveau

Das unter Erweiterte Optionen festgelegte Konfidenzniveau wird in der Signifikanz-Berechnung verwendet, um den Variationsumfang festzulegen, den die Ergebnisse haben können, bevor sie als statistisch signifikant angesehen werden. Je höher Sie das Konfidenzniveau setzen, desto „sicherer“ muss die Berechnung sein, dass eine Version mit einem statistisch bedeutenden Unterschied gewinnt. Das bedeutet, wie hoch die Standardabweichung der Berechnung sein kann, bevor die Ergebnisse als signifikant gewertet werden. Wenn mehr Daten in einem Test verwendet werden, bedeutet das normalerweise, dass die Standardabweichung sinkt und daher der Prozentsatz für das Vertrauen in diese Ergebnisse steigt.

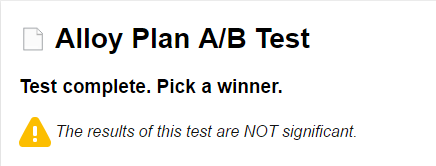

Nach Abschluss des Tests und nach der Berechnung des Ergebnisses auf der Grundlage des festgelegten Konfidenzniveaus erscheint ein Bericht oben im Fenster Gewinner bestimmen.

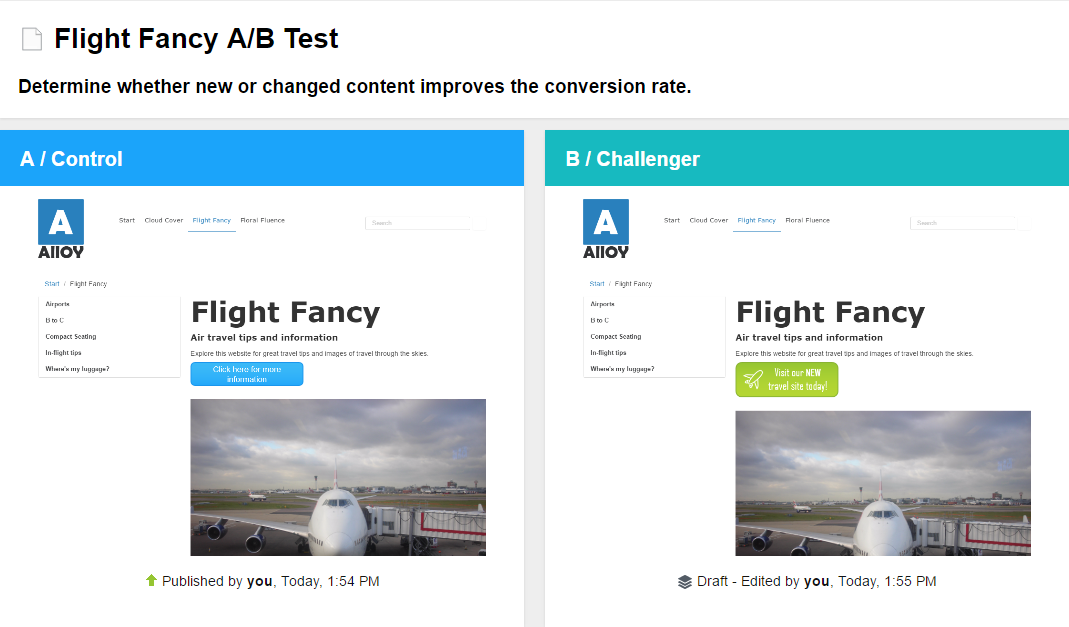

Start eines A/B-Tests

- Beginnen Sie mit einer veröffentlichten Version einer Seite oder eines Blocks als Original (A / Kontrolle). Sie führen zum Beispiel eine Seite mit Flugreisetipps und möchten die Besucher zum Entdecken der Inhalte Ihrer Seite animieren. Wird eine ausgefallene grafische Schaltfläche ein höheres DurchklickenDas Folgen eines Hypertext-Links zu einer bestimmten Website, insbesondere zu einer Commerce-Site. erreichen als eine Schaltfläche, auf der nur Text zu sehen ist?

- Erstellen Sie einen Entwurf, indem Sie die Schaltfläche ändern oder sonstige Änderungen an der Seite durchführen:

-

Bild in Version A / Kontrolle: Bild in Version B / Herausforderung:

- Wählen Sie Veröffentlichen? aus > A/B-Teständerungen. Veröffentlichen Sie die geänderte Seite nicht. Die A/B-Testansicht erscheint und zeigt Miniaturansichten von A / Kontrolle und B / Herausforderung an.

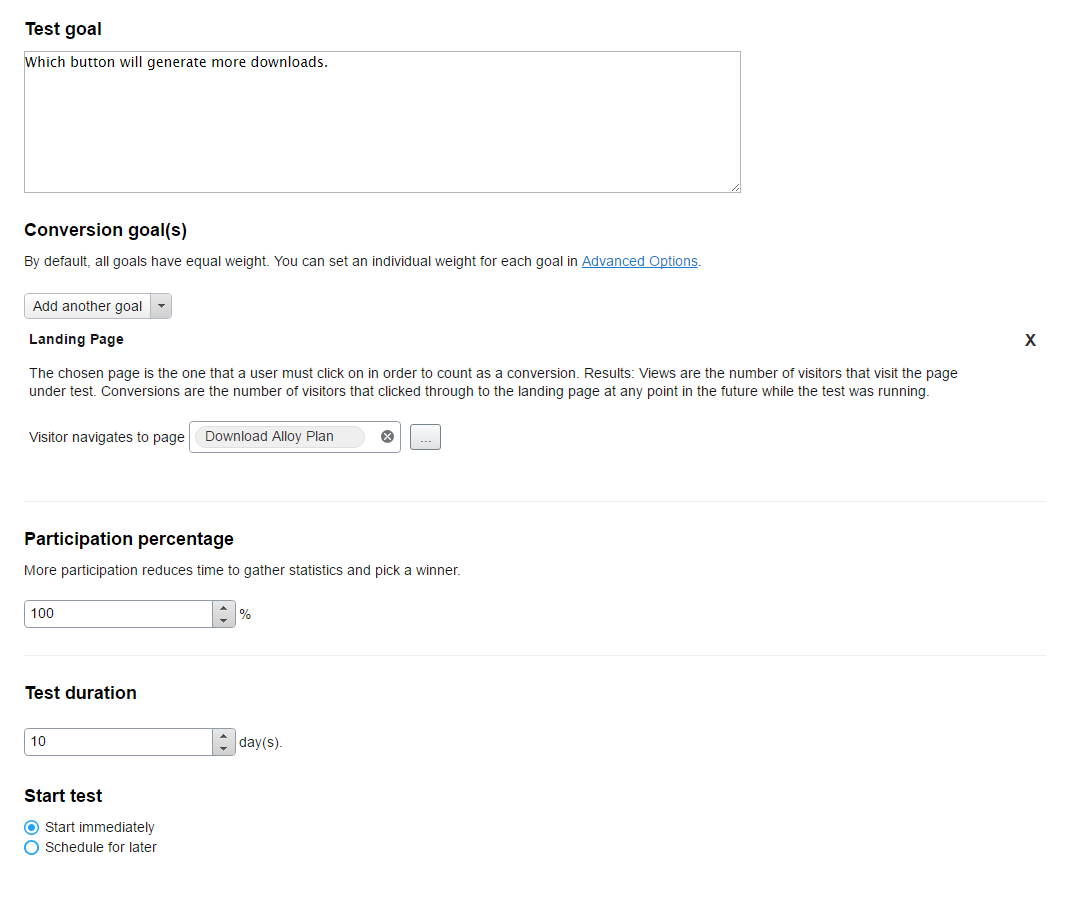

- Konfigurieren Sie Ihren A/B-Test mit folgenden Optionen:

Option Beschreibung Testziel Geben Sie Ihre Hypothese für den Test ein. Dies dient nur zu Ihrer Information. Konversionsziel(e) Wählen Sie ein oder mehrere Konversionsziel(e) aus, das/die Sie messen möchten. (Konversionsziele werden auch als Schlüssel-Performanceindikatoren oder KPIs (Key Performance Indicators) bezeichnetSiehe Konversionsziel..) Sie können bis zu fünf Konversionsziele für den A/B-Test festlegen und unter Erweiterte Optionen entscheiden, ob einige Ziele gegenüber anderen zu bevorzugen sind. - Landeseite. Wählen Sie eine Zielseite aus, zu der die Besucher beim Durchklicken geführt werden sollen. Nur ein Durchklicken wird als Konversion gewertet.

- Verweildauer auf der Seite. Wählen Sie eine Zielseite und eine Testdauer (1 - 60 Minuten) aus. Der A/B-Test zählt als Konversion, wenn ein Besucher während der Testzeit von der Zielseite auf jegliche andere Seite auf Ihrer Website weiterklickt. Wenn der Besucher den Browser schließt und Ihre Zielseite innerhalb der Testzeit erneut öffnet, wird dies nicht als neuer Seitenaufruf gezählt. Eine Konversion wird jedoch gezählt, wenn der Besucher bei diesem zweiten Besuch von der Zielseite auf eine andere Seite weiterklickt.

- Zeit auf der Seite. Geben Sie eine Zeit in Sekunden ein. Der A/B-Test zählt eine Konversion, wenn ein Besucher die festgelegte Zeit auf der Testseite verbringt.

- In den Warenkorb legen. Auswahl eines Produkts, dass der Seitenbesucher in den Warenkorb legen kann. Wenn der Besucher das Produkt in den Warenkorb legt, wird dies als Konversion gezählt.

- Durchschnittliche Bestellung. Wählen Sie dieses Konversionsziel aus, um abgeschlossene Bestellungen auf jeder der Testseiten zu verfolgen. Dieses Konversionsziel summiert die Werte aller erstellten E-Commerce-Warenkörbe einschließlich der in den A/B-Test aufgenommenen Besucher. Der Test bestimmt, welche Seitenversion den höchsten Durchschnittswert für alle diese Warenkörbe erzielt, wenn ein Gewinner ermittelt wird. Füllt ein Besucher mehrere Warenkörbe, werden alle (bezahlten) Warenkörbe in die Summe einbezogen. Der gleiche Besucher kann also während der Testzeit mehrmals „konvertieren“. Auf Commerce-Websites in verschiedenen Währungen rechnet der Test alle Warenkörbe in die gleiche Währung um.

- Produkt kaufen. Auswahl eines Produkts, dass der Seitenbesucher kaufen kann. Wenn der Besucher das Produkt kauft, wird dies als Konversion gezählt.

Hinweis: Sie benötigen Episerver Commerce, um mit Commerce in Verbindung stehende Konversionsziele wie zum Beispiel In den Warenkorb legen, Produkt kaufen und Durchschnittliche Bestellung zu nutzen.

Teilnahmeprozentsatz Geben Sie einen Prozentsatz für die Gesamt-Verkehrsmenge zu Ihrem A/B-Test ein. Wenn Sie diesen auf 100 % setzen, nehmen alle Website-Besucher am Test teil. Die Hälfte der Teilnehmer werden Version A, die andere Hälfte Version B sehen.

Jedoch möchten Sie vielleicht nicht, dass so viele Besucher die Version B sehen. Das kann dann der Fall sein, wenn Sie den Inhalt als nicht erfolgsversprechend ansehen. Dies können Sie durch eine Verringerung des Prozentsatzes der in den Test miteinbezogenen Besucher erreichen. Die nicht im Test miteinbezogenen Besucher sehen Version A. Nur die in den Test aufgenommenen Besucher zählen in der Statistik.

Testdauer Angabe der Tage, die der Test laufen soll. Test starten Wählen Sie eine der Optionen aus. Sie können den Test jederzeit abbrechen, bevor die festgelegte Dauer abgelaufen ist. - Test sofort starten. Wählen Sie diese Option aus und klicken Sie auf Test starten, nachdem Sie die Testparameter angegeben haben.

- Einen späteren Zeitpunkt festlegen. Mit dieser Option öffnet sich ein Auswahlkalender. Wählen Sie Datum und Uhrzeit für den Beginn des Tests aus. Klicken Sie auf die Schaltfläche Test planen, nachdem Sie die Testparameter angegeben haben.

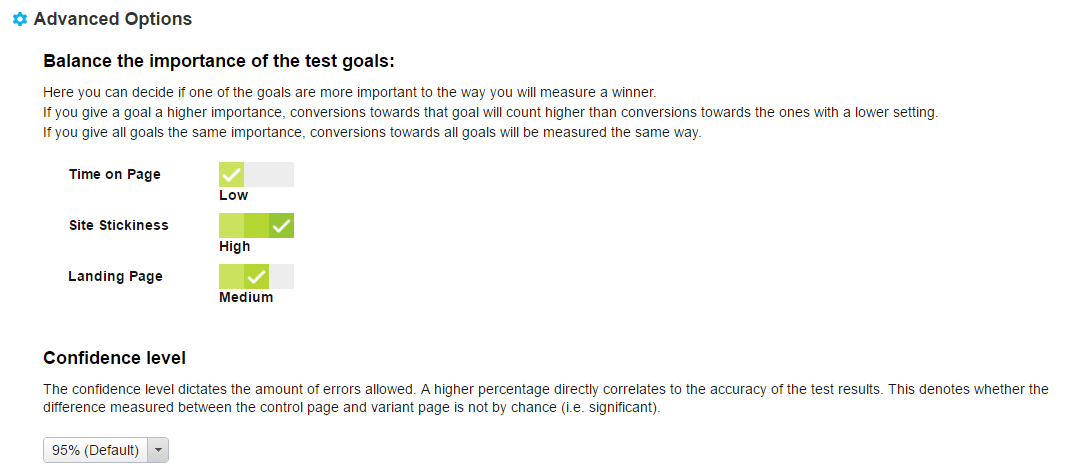

Erweiterte Optionen - Gewichtung der Testziele festlegen. Wählen Sie aus, ob ein Ziel mehr oder weniger wichtiger als die anderen ist. Wenn Sie zwei Konversionsziele auf Hoch (oder niedrig) setzen, ist das so, als würden Sie sie auf Mittel setzen, da sie dann die gleiche Wichtigkeit aufweisen und sich das nicht auf das Testergebnis auswirkt. Wenn Sie andererseits nur ein Konversionsziel festlegen, hat die gewählte Gewichtung keine Auswirkung auf das Testergebnis.

- Konfidenzniveau. Wählen Sie das Konfidenzniveau der statistischen Signifikanz für die Ergebnisse aus, die Sie erhalten möchten. Je höher Sie das Konfidenzniveau setzen, desto „sicherer“ muss die Berechnung sein, dass die gewinnende Version mit einem statistisch bedeutenden Unterschied gewinnt.

- Klicken Sie auf Test starten, wenn Sie den Test auf sofortigen Start eingestellt haben, oder auf Test planen, wenn er zu einem späteren Zeitpunkt durchgeführt werden soll.

Beobachtung eines laufenden A/B-Tests

- Öffnen Sie zum Beobachten eines laufenden A/B-Tests die Testseite und klicken auf Test anzeigen in der Benachrichtigungsleiste.

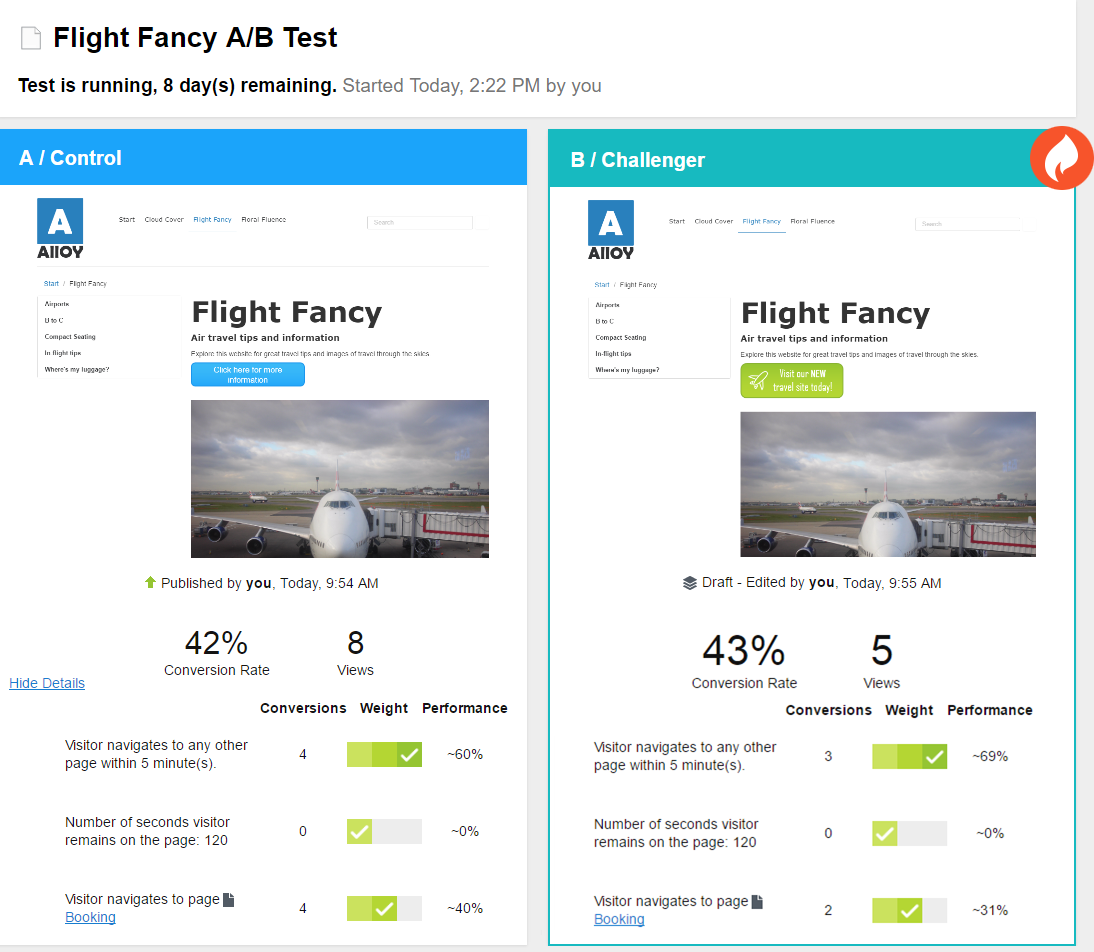

Die Testergebnisse werden angezeigt und ein Flammensymbol zeigt an, welche Version gerade führt:

.

.Unter den beiden Seiten-Miniaturansichten sehen Sie die bisher gesammelten Testdaten, zum Beispiel die Anzahl der Aufrufe und Konversionen sowie die Konversionsraten. Wenn Sie mehrere Konversionsziele festgelegt haben, sehen Sie deren Gewichtung und wie diese zurzeit abschneiden. Bei einem einzigen Konversionsziel sehen Sie die Testdaten und die Konversionsrate als Tortendiagramm. Die Konversionsrate kann ein Prozentsatz oder eine Anzahl sein, wenn Sie Durchschnittsbestellung-KPI verwenden. (Das Tortendiagramm wird für Durchschnittsbestellungs-KPI nicht angezeigt.)

Statistische Signifikanz des Tests wird berechnet, wenn der Test abgeschlossen ist. Bis dahin kann nicht gesagt werden, ob die Testergebnisse signifikant sind oder nicht.

- Sie können im Menü Optionen folgende Aktionen auswählen:

- Gewinner bestimmen. Wenn Sie schon vor Ende des Tests genug Daten gesehen haben, können Sie den Test stoppen und den Gewinner bestimmen. Eine geänderte Seite könnte zum Beispiel schon so eindeutig gewonnen haben, dass eine Testung über weitere Tage das Ergebnis nicht signifikant beeinträchtigen würde.

Wenn Sie Gewinner bestimmen auswählen, erscheint die Ansicht zur Gewinnerbestimmung. Der Gewinner wird in grün hervorgehoben. Klicken Sie auf Gewinner bestimmen und das Ergebnis wird automatisch veröffentlicht. Nach Bestimmung des Gewinners wird der Verlierer als Verlaufselement in das Versionen Gadget aufgenommen.

- A/B-Test abbrechen. Stoppt den Test und verwirft die Ergebnisse.

- Gewinner bestimmen. Wenn Sie schon vor Ende des Tests genug Daten gesehen haben, können Sie den Test stoppen und den Gewinner bestimmen. Eine geänderte Seite könnte zum Beispiel schon so eindeutig gewonnen haben, dass eine Testung über weitere Tage das Ergebnis nicht signifikant beeinträchtigen würde.

Den Gewinner bestimmen

Ja nach Konfiguration Ihrer Site kann der Testgewinner nach Abschluss des Tests automatisch, oder während oder nach dem A/B-Test manuell von Ihnen veröffentlicht werden.

Automatische Veröffentlichung eines Testgewinners

Ein Administrator kann Ihre Seite so eingestellt haben, dass die A/B-Testgewinner nach Abschluss der Tests automatisch veröffentlicht werden, wenn die Testergebnisse signifikant sind. Ist diese Einstellung gesetzt, betrifft das alle Tests auf Ihrer Website. Sobald ein Test zu Ende geht, wird der Gewinner veröffentlicht. Sind die Testergebnisse jedoch nicht statistisch signifikant, müssen eine der Testversionen manuell veröffentlichen.

Manuelle Veröffentlichung eines Testgewinners

Wenn Sie Veröffentlichungsrechte haben, können Sie einen Testgewinner veröffentlichen, noch während der Test läuft, oder warten, bis er zu Ende geht.

- Um einen beendeten A/B-Test anzuzeigen, öffnen Sie die Seite, die Sie testen und klicken auf Gewinner bestimmen in der Benachrichtigungsleiste.

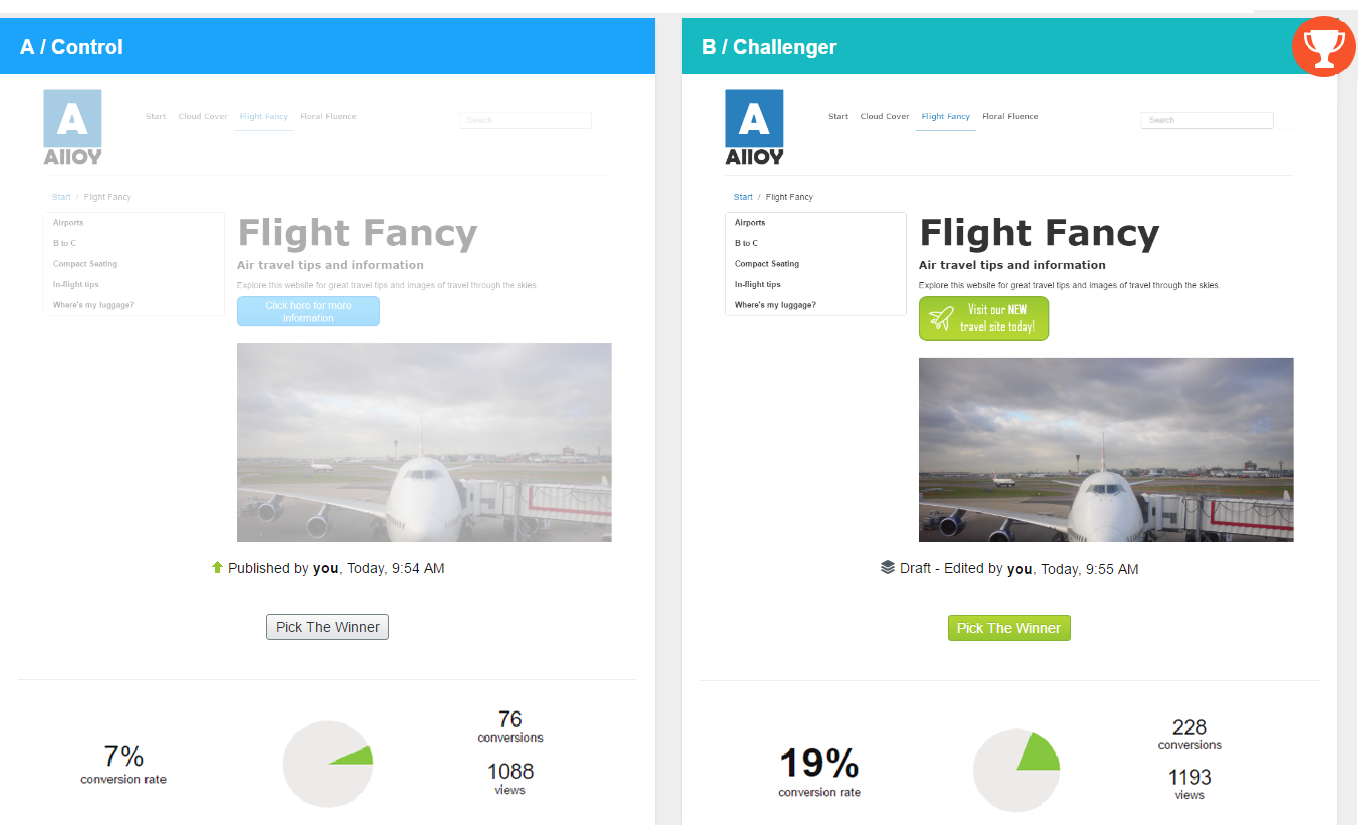

Die Testergebnisse werden angezeigt.

Oben im Testergebnisfenster sehen Sie die Ergebnisse, die statistisch signifikant sind.

Der Testgewinner wird auf grünem Hintergrund und mit einer Pokal-Graphik hervorgehoben:

. Die Schaltfläche Gewinner bestimmen des Testgewinners ist grün, aber Sie können jede der Versionen veröffentlichen.

. Die Schaltfläche Gewinner bestimmen des Testgewinners ist grün, aber Sie können jede der Versionen veröffentlichen.Unter den beiden Seiten-Miniaturansichten sehen Sie die bisher gesammelten Testdaten, zum Beispiel die Anzahl der Aufrufe und Konversionen sowie die Konversionsrate. Wenn Sie mehrere Konversionsziele festgelegt haben, sehen Sie, wie diese abgeschnitten haben.

- Wenn Sie auf Gewinner bestimmen der gewünschten Version klicken, wird diese sofort veröffentlicht.

Der Verlierer bleibt im Versionen-Gadget verfügbar.

A/B-Tests verwalten

Während ein Test läuft, können Sie weder die Testeinstellungen noch den Inhalt der Testseite bearbeiten, da dies die Ergebnisse verfälschen könnte. Wenn Sie die Testeinstellungen oder etwas am Inhalt der Testseite ändern wollen, müssen Sie den Test abbrechen, die Änderungen vornehmen und den Test dann erneut starten. Sie können einen Test im Menü Optionen in der Testansicht oder in der Testseite selbst abbrechen. Wenn Sie einen Entwurf auf der Testseite öffnen, wird das Menü Optionen als Veröffentlichen? bezeichnet.

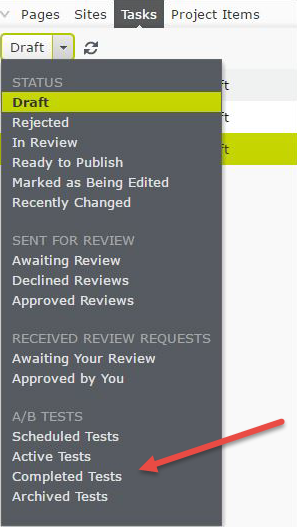

Öffnen Sie die Registerkarte Aufgaben in der Navigationsansicht, um die A/B-Tests zu finden.

|

|

| Geplante Tests. Zeigt die Links zu Tests an, die für später programmiert sind. Aktive Tests. Zeigt die Links zu den aktiven Testseiten an, die Daten ermitteln. Klicken Sie auf ein Element, um die Testseite zu öffnen, in der Sie auf den Link Test anzeigen klicken und damit einen Schnappschuss der Ergebnisdaten anzeigen können. Abgeschlossene Tests. Zeigt die Links zu den abgeschlossenen Tests an. Zu diesen werden keine weiteren Daten erhoben. Ein Gewinner wurde noch nicht veröffentlicht. Archivierte Tests. Zeigt die Links zu den abgeschlossenen Test an, für die ein Gewinner veröffentlicht wurde. |

Für andere Status in der Aufgabenleiste siehe Steuerung des Veröffentlichungsprozesses.

Abgeschlossene und archivierte Tests ansehen

Im Aufgabenbereich können Sie alle mit A/B-Tests getesteten Seiten sehen, indem Sie auf Aktive Tests, Abgeschlossene Tests, oder auf Archivierte Tests klicken. (Ein abgeschlossener Test ist beendet, sein Gewinner aber noch nicht veröffentlicht. Ein archivierter Test ist abgeschlossen und sein Gewinner wurde veröffentlicht.)

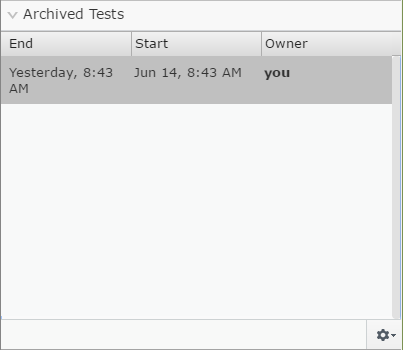

Um einen einzelnen Testlauf auf einer spezifischen Seite zu sehen, fügen Sie das Gadget Archivierte Tests in den Navigations- oder Asset-Bereich und öffnen die getestete Seite. Das Gadget zeigt nun alle archivierten Testläufe auf der aktuellen Seite an. Ein Klick auf einen dieser Tests im Gadget ruft die zugehörigen Testeinzelheiten auf. Siehe Gadgets verwalten, um zu erfahren, wie Sie Gadgets zur Bearbeitungsansicht hinzufügen und wieder aus ihr entfernen.

Standardwerte zum A/B-Testing einstellen

Administratoren können die Standardwerte einstellen und entscheiden, ob ein Testgewinner automatisch veröffentlicht wird oder nicht. Siehe A/B-Test-Konfiguration in den Tool-Einstellungen.

Brauchen Sie Hilfe?

Brauchen Sie Hilfe?